Czy kiedykolwiek zastanawiałeś się, czy to, co widzisz w internecie, jest prawdziwe? W dzisiejszych czasach rozwijającej się technologii i sztucznej inteligencji, wiele nagranych materiałów wideo okazuje się być fałszywymi. Tak zwane “deep fake” stają się poważnym wyzwaniem dla społeczeństwa i mają duży wpływ na rozwój biometrii. Dlatego też warto przyjrzeć się temu zjawisku bliżej.

Deep fake w 2023

Światowi przywódcy niespodziewanie pojawiają się w roli muzyków zespołu Limp Bizkit w teledysku. Jedna ze stacji telewizyjnych tworzy serial komediowy, w którym zamiast aktorów występują deep fake’owe odpowiedniki znanych osobistości. Takie sytuacje nie są już niczym niezwykłym. Każdego dnia do sieci trafiają kolejne materiały prezentujące aktorów, celebrytów czy streamerów w dziwnych sytuacjach i budzących zaskoczenie wypowiedziach. Deep fake, jako technika obróbki treści prowadząca do stworzenia fałszywego obrazu i dźwięku, nie przestaje zaskakiwać i nie bez przyczyny wskazywana jest jako jedno z największych wyzwań współczesnego świata.

Sztuczna inteligencja potrafi bez większych kłopotów oszukać człowieka, pozwalając mu wierzyć, że to, co odbiera zmysłami wzroku i słuchu jest prawdą. W tym przypadku szanse odbiorcy na zorientowanie się są niestety niewiele wyższe od decydowania na bazie rzutu monetą. Potwierdziły to eksperymenty przeprowadzone przez badaczy z uniwersytetów w Kalifornii i Lancaster. Choć naukowcy nie wykorzystali najnowocześniejszych algorytmów SI, wymyślone przez nich twarze uczestnicy próby zdołali wskazać w zaledwie 48% przypadków. Nawet wcześniejszy trening i udzielenie kilku cennych wskazówek niewiele poprawiło wynik – skuteczność nadal nie przekroczyła 60%. Co warto dodać – zdjęcia fikcyjnych osób wywoływały o 7,7% większe zaufanie u grupy badawczej niż fotografie prawdziwych ludzi.

Dysponując już teraz takimi możliwościami, deep fake nie tylko może przyczyniać się do szybko rosnącej dezinformacji, ale również bezprecedensowego wzrostu cyberprzestępczości. Oznacza też duże wyzwanie dla rozwiązań z zakresu biometryki.

Deep fake a biometryka

Ostrzeżenie, że cyberprzestępcy wkrótce zaczną korzystać ze sztucznej inteligencji jest nieaktualne. Deep fake już dziś stanowi jedną ze skutecznych strategii prowadzenia ataków. Próby wykonywane przez ekspertów ds. cyberbezpieczeństwa pokazują, że hakerzy mogą łatwo obejść zabezpieczenia głosowe, tworząc tylko na komputerze odpowiednie próbki mowy użytkownika. W ten sposób są w stanie dostać się do systemu bankowego, radząc sobie z technologią Voice ID.

Oszuści wykorzystują nowe możliwości do tworzenia unikalnego planu ataku, na który wiele organizacji i osób jest nieprzygotowanych. W efekcie potrafią nakłonić do powierzenia im cennych danych lub środków finansowych. Ich pomysłowość najlepiej obrazują ostatnie doniesienia o hakerach, którzy w ten sposób byli w stanie nawet przejść przez proces zdalnych rekrutacji i zdobyć posady w firmach. Umożliwił im to fałszywy profil stworzony za pomocą algorytmów.

Znane od dekady metody ataku przechodzą rewolucję, a cyfrowi przestępcy znajdują sposoby, by skutecznie radzić sobie z nowymi zabezpieczeniami. To wymusza ciągły rozwój rozwiązań do ochrony cyfrowych zasobów. Choć biometryka cieszy się coraz większą popularnością i zaufaniem użytkowników, jej skuteczność także zależy od reagowania na zauważalne postępy SI oraz kreatywność cyberprzestępców. Tylko przez sześć ostatnich miesięcy 2022 roku liczba ataków hakerów wykorzystujących model podmiany twarzy użytkownika za pomocą ataku typu digital injection wzrosła o niebotyczne 295%. Czytając takie doniesienia można mieć wątpliwości, czy system rozpoznawania twarzy ma jeszcze sens w kategorii skutecznych form ochrony dostępu.

Facial Recognition Systems w dobie deep fake’ów

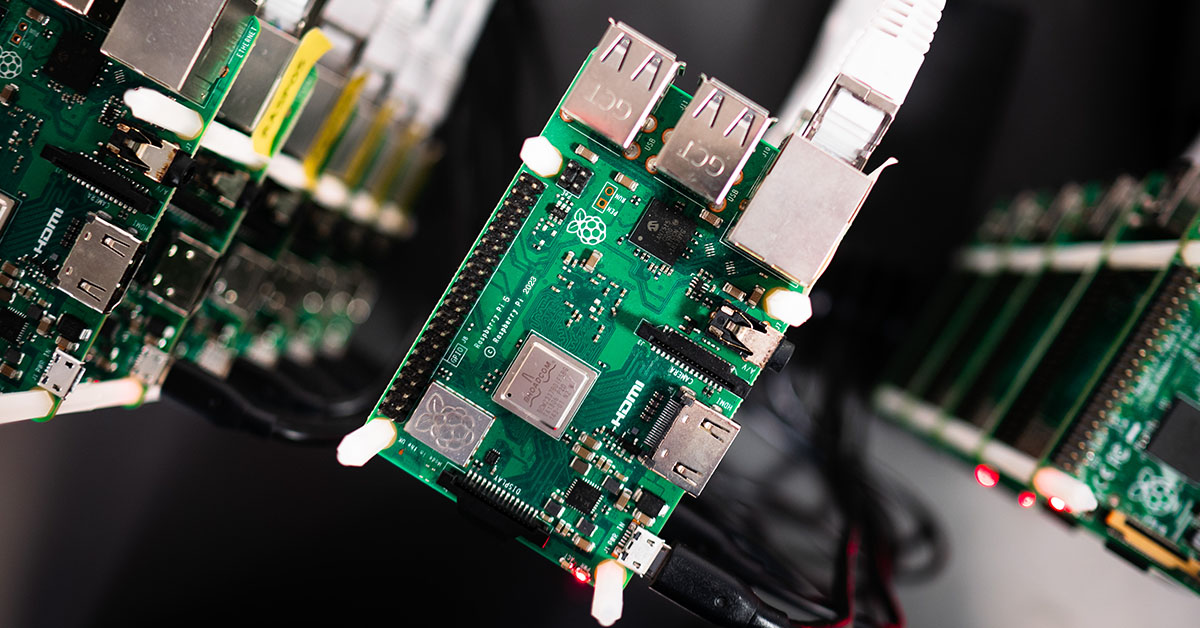

Wspominaliśmy już na naszym blogu, że systemy rozpoznawania twarzy można oszukać, wykorzystując słabości algorytmów lub wprowadzając je w błąd. Nie wpływa to jednak na coraz większą popularność facial recognition. Zabezpieczenia biometryczne są z powodzeniem implementowane na lotniskach lub w bankach, a także używane na co dzień przez posiadaczy smartfonów. Rozwój technologii deep fake sprawia, że sytuacja może ulec zmianie, o ile twórcy rozwiązań nie zareagują odpowiednio szybko na nowe zagrożenia bezpieczeństwa.

Sytuacja przypomina obecnie dynamiczny wyścig, w którym obie strony próbują się przechytrzyć i prześcignąć. W odpowiedzi na działania hakerów, którzy na różne sposoby starają się oszukać systemy, ich twórcy wdrażają i unowocześniają rozwiązania antyspoofingowe. Szczególną rolę odgrywają techniki rozpoznawania tożsamości (Liveness Detection), które pozwalają walczyć z próbami uzyskania dostępu przez osoby niepowołane za pomocą wydrukowanych zdjęć, masek 3D czy nagrań wideo.

Wdrażane rozwiązania tego typu monitorują na bieżąco wiele różnych aspektów – od rozszerzania źrenic, przez naturalność ruchów ust i oczu oraz całej głowy, po analizę tekstury skóry. Czasami też wiążą się z prośbą o wykonanie przez drugą stronę konkretnej czynności, na przykład ruchu głowy, który pozwala kamerze 3D zmapować twarz rozmówcy. Ich celem jest wykonanie weryfikacji w czasie rzeczywistym, która pozwala określić, czy po drugiej stronie występuje prawdziwa osoba, a nie tylko podszywające się pod nią nagranie lub obraz.

Dobre praktyki w dobie deep fake’ów

Na popularność technologii wpływają nie tylko jej duże możliwości, ale również łatwość dostępu. Obecna sytuacja potwierdza, że dziś prościej niż kiedykolwiek wcześniej zostać cyberprzestępcą. W darknecie hakerzy mogą bez większych trudności i w przystępnych cenach zakupić narzędzia oferowane przez grupy przestępcze, które umożliwiają im przeprowadzenie ataku na dany system czy konto użytkownika przy użyciu deep fake’ów.

Co mogą zrobić organizacje, które chcą chronić posiadane zasoby i pracowników? Rozwiązania technologiczne stanowią pierwszą barierę, ale nieodzowna jest edukacja i uświadamianie o skali zagrożenia. Informowanie klientów, kontrahentów, akcjonariuszy i zatrudnionych specjalistów o potencjalnych oszustwach przy użyciu deep fake’ów zwiększa ich czujność i może w kluczowych momentach zapobiec poważnym konsekwencjom biznesowym. Nowa rzeczywistość wymusza zmiany w politykach bezpieczeństwa, ale również unowocześnienie wewnętrznych procesów, m.in. onboardingowych, które pozwalają nowym pracownikom lepiej przygotować się na wyzwania i zagrożenia związane z metodami wdrażanymi przez hakerów.

Cyfrowe ryzyko nadal rośnie. W dobie szybko pędzącego świata, który każdego dnia wytwarza kwintyliony danych, fake newsy i deep fake’i mogą stanowić potężne narzędzie w rękach doświadczonych cyberprzestępców. Po stronie specjalistów IT i firm z sektora duże wyzwanie stawienia im czoła w ramach rozwoju technologii pomagających chronić prywatne informacje czy dostępy. Z pewnością ten specyficzny wyścig zbrojeń będzie trwał jeszcze długimi latami.

Bądź blisko innowacji z GlobalLogic

Nasze zespoły blisko współpracują z czołowymi organizacjami z sektorów automotive, healthcare, finansowego, przemysłowego czy mediowego. Rozwijają nowe technologie i projektują rozwiązania, które usprawniają procesy, ale również wpływają na bezpieczeństwo partnerów biznesowych i indywidualnych użytkowników. Chcesz być częścią tego świata i nieustannie się rozwijać? Sprawdź, co oferujemy! Aktualne oferty pracy znajdziesz w zakładce kariera.

BlogsGlobalLogicJuly 24, 2024

BlogsGlobalLogicJuly 24, 2024

Press ReleaseGlobalLogicJanuary 7, 2025

Press ReleaseGlobalLogicJanuary 7, 2025