-

-

-

-

URL copied!

In den letzten Jahrzehnten wurden riesige Datenmengen aus verschiedenen Quellen generiert. Unternehmen wollen zunehmend neue Datenparadigmen nutzen, um bessere Entscheidungen zu treffen und Maßnahmen zu ergreifen. So können sie ihre Effizienz steigern, neue Wege der Geschäftsabwicklung beschreiten und Ausgaben optimieren.

Viele Unternehmen haben jedoch mit Datenproblemen zu kämpfen, die auf die komplexen Technologiepakete und Datenpipelines zurückzuführen sind, die sich aufgrund neuer Geschäftsziele ständig ändern. Es ist unerlässlich geworden, Best Practices für die Implementierung von Datenqualitäts- und Validierungstechniken zu nutzen, um sicherzustellen, dass die Daten für weitere Analysen zur Gewinnung von Erkenntnissen nutzbar bleiben.

In diesem Blog befassen wir uns mit den Anforderungen an die Datenqualität und dem Kerndesign einer Lösung, mit der Unternehmen Datenqualität und -validierung auf flexible, modulare und skalierbare Weise durchführen können.

Anforderungen an die Datenqualität

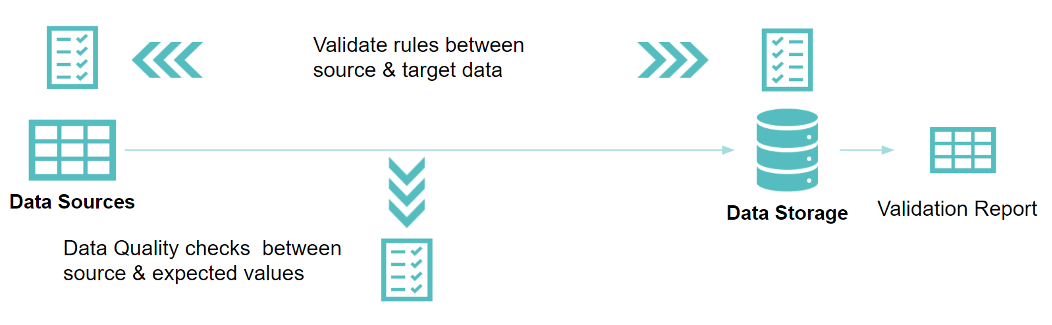

Eine Datenplattform integriert Daten aus einer Vielzahl von Quellen, um verarbeitete und bereinigte Datensätze, die den Qualitäts- und Regulierungsanforderungen entsprechen, für Analysesysteme bereitzustellen, damit daraus Erkenntnisse gewonnen werden können. Die Daten, die von den Datenquellen in die Speicherebenen übertragen werden, müssen validiert werden, entweder als Teil der Datenintegrationspipeline selbst oder durch einen unabhängigen Vergleich zwischen der Quelle und der Senke.

Im Folgenden sind einige der Anforderungen aufgeführt, die eine Datenqualitäts- und Validierungslösung erfüllen muss:

- Datenvollständigkeit prüfen: Validierung der Ergebnisse zwischen den Quell- und Zieldatenquellen, z. B.:

- Vergleich der Zeilenzahl über Spalten hinweg

- Vergleich der Ausgabe von Spaltenwertaggregationen

- Vergleich einer Teilmenge von Daten ohne Hashing oder eines vollständigen Datensatzes mit SHA256-Hashing aller Spalten

- Vergleich von Profiling-Statistiken wie Minimum, Maximum, Mittelwert, Quantile

- Schema/Metadaten prüfen: Validierung der Ergebnisse zwischen Quelle und Ziel oder zwischen der Quelle und einem erwarteten Wert.

- Überprüfung von Spaltennamen, Datentyp, Reihenfolge oder Position der Spalten, Datenlänge

- Datenumwandlungen prüfen: Validieren Sie den Zwischenschritt der tatsächlichen Werte mit den erwarteten Werten.

- Benutzerdefinierte Datentransformationsregeln prüfen

- Überprüfung der Datenqualität, z. B. ob die Daten im Bereich liegen, in einer Referenzsuche, einem Domänenwertvergleich oder ob die Zeilenzahl mit einem bestimmten Wert übereinstimmt

- Prüfung von Datenintegritätsbeschränkungen wie nicht null, Eindeutigkeit, kein negativer Wert

- Validierung der Datensicherheit: Überprüfen Sie verschiedene Sicherheitsaspekte, wie z. B.:

- Überprüfen, ob die Daten mit den geltenden Vorschriften und Richtlinien konform sind

- Identifizierung von Sicherheitsschwachstellen in der zugrunde liegenden Infrastruktur, den verwendeten Tools oder dem Code, die sich auf die Daten auswirken können

- Identifizierung von Problemen auf der Ebene des Zugriffs, der Autorisierung und der Authentifizierung

Durchführen von Bedrohungsmodellen und Testen von Daten im Ruhezustand und bei der Übertragung

- Validierung der Datenpipeline: Überprüfen von Pipeline-bezogenen Aspekten, wie z. B. ob:

- die erwarteten Quelldaten ausgewählt werden

- die erforderlichen Operationen in der Pipeline den Anforderungen entsprechen (z. B. Aggregation, Transformationen, Bereinigung)

- Die Daten werden an das Ziel geliefert.

- Validierung der Code- und Pipeline-Bereitstellung: Validierung, ob die Pipelines mit dem Code korrekt in der erforderlichen Umgebung bereitgestellt wurden

- Nahtlose Skalierung für große Datenmengen

- Unterstützung der Orchestrierung und Planung von Validierungsaufträgen

- Bereitstellung eines Low-Code-Ansatzes zur Definition von Datenquellen und Konfiguration von Validierungsregeln

- Generierung eines Berichts, der Details zu den Validierungsergebnissen der konfigurierten Regeln für alle Datensätze enthält

Überblick über die Lösung

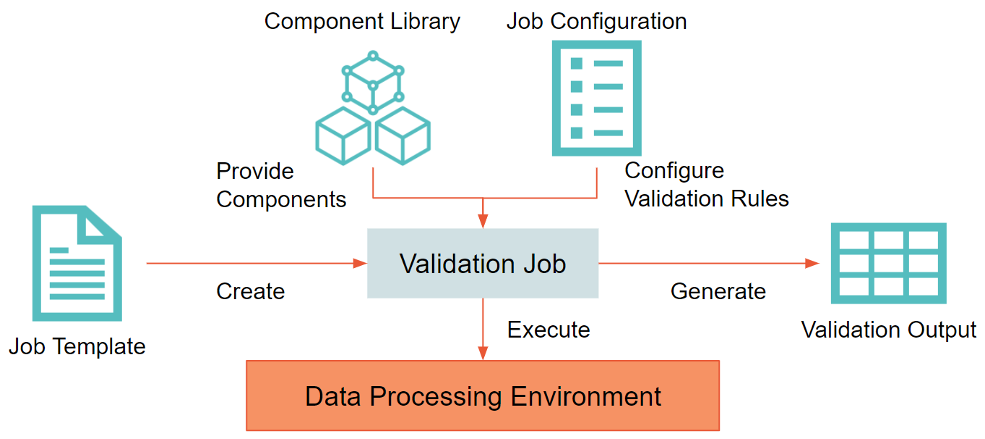

Nachfolgend finden Sie einen allgemeinen Entwurf für eine Datenqualitäts- und -validierungslösung, die die oben genannten Anforderungen erfüllt.

- Komponenten-Bibliothek (Component Library): Verallgemeinern Sie die üblicherweise verwendeten Validierungsregeln als eigenständige Komponente, die über eine vordefinierte Komponentenbibliothek out-of-box bereitgestellt werden kann.

- Komponenten (Components): Für fortgeschrittene Benutzer oder für bestimmte Szenarien können benutzerdefinierte Validierungsregeln erforderlich sein. Diese können durch ein erweiterbares Framework unterstützt werden, das die Hinzufügung neuer Komponenten zur bestehenden Bibliothek unterstützt.

- Auftragskonfiguration (Job Configuration): Ein typischer QA-Tester bevorzugt eine Low-Code-Methode zur Konfiguration der Validierungsaufträge, ohne selbst Code schreiben zu müssen. Eine JSON- oder YAML-basierte Konfiguration kann verwendet werden, um die Datenquellen zu definieren und die verschiedenen Validierungsregeln zu konfigurieren.

- Datenverarbeitungs-Engine (Data Processing Engine): Die Lösung muss in der Lage sein, große Datenmengen zu verarbeiten. Ein Big-Data-Verarbeitungsframework wie Apache Spark kann zum Aufbau des Grundgerüsts verwendet werden. Dadurch kann der Auftrag in jeder Datenverarbeitungsumgebung, die Spark unterstützt, bereitgestellt und ausgeführt werden.

- Auftragsvorlagen (Job Templates): Vordefinierte Auftragsvorlagen und anpassbare Auftragsvorlagen bieten eine standardisierte Möglichkeit zur Definition von Validierungsaufträgen.

- Validierungsausgabe (Validation Output): Die Ausgabe des Auftrags sollte ein konsistenter Validierungsbericht sein, der eine Zusammenfassung der ausgegebenen Validierungsregeln über die konfigurierten Datenquellen hinweg liefert.

Beschleunigen Sie Ihre eigene Reise in Sachen Datenqualität

Bei GlobalLogic arbeiten wir an einem ähnlichen Ansatz als Teil unserer GlobalLogic Data Platform. Die Plattform umfasst einen Data Quality and Validation Accelerator, der ein modulares und skalierbares Framework bietet, das in serverlosen Spark-Umgebungen in der Cloud eingesetzt werden kann, um eine Vielzahl von Quellen zu validieren.

Wir arbeiten regelmäßig mit unseren Kunden zusammen, um sie bei ihrer Data Journey zu unterstützen. Teilen Sie uns Ihre Anforderungen mit, und wir würden uns freuen, mit Ihnen über die nächsten Schritte zu sprechen.

Top Insights

Top Authors

Blog Categories

Auf gute Zusammenarbeit!

Ähnliche Themen

Sieben Schlüssel, um Mitglied eines effektiven Teams zu sein

Ein großartiger Entwickler muss sowohl seine technischen Fähigkeiten als auch seine Soft Skills stetig verbessern, denn beides bildet die Grundlage für jeden Profi, der im Team effektiv sein und positive Veränderungen innerhalb seines Unternehmens inspirieren möchte. Basierend auf meiner Erfahrung als Softwareentwickler habe ich eine Reihe von Empfehlungen zusammengestellt, die ich als entscheidend für die … Continue reading Design einer skalierbaren und modularen Lösung für Datenqualität und Datenvalidierung →

Mehr erfahren

5 Gründe, warum Ihr Projekt einen Business Analyst braucht

Die Durchführung eines Projekts ist eine komplexe Herausforderung. Als Produktmanager stehen Sie vor der ständigen Aufgabe, Ihr Unternehmen erfolgreich zu führen – von der Definition der Vision über den Umgang mit Kunden bis hin zur Lieferung messbarer Ergebnisse. In diesem Artikel erfahren Sie, warum die Einbindung eines Business Analysts (BA) in Ihr Team nicht nur … Continue reading Design einer skalierbaren und modularen Lösung für Datenqualität und Datenvalidierung →

Mehr erfahren

Innovative Technologien für Natur und Smart Cities

In der Welt der Innovation zählt jede Idee. Selbst kleine Einfälle können revolutionäre Veränderungen bewirken, die unseren Alltag, unsere Arbeitsweise und unsere Beziehung zur Natur nachhaltig beeinflussen. Ein hervorragendes Beispiel dafür ist ein Projekt, an dem Studierende gemeinsam mit Ingenieuren von GlobalLogic in Zielona Góra gearbeitet haben. Diese Zusammenarbeit führte zu modernen Lösungen, die die … Continue reading Design einer skalierbaren und modularen Lösung für Datenqualität und Datenvalidierung →

Mehr erfahren

Die Zukunft der erneuerbaren Energien und Smart Cars: Eine doppelte technologische Revolution

Während die Welt mit dem Klimawandel und der Notwendigkeit nachhaltigen Wachstums ringt, treten zwei Sektoren als entscheidende Akteure in den Vordergrund: erneuerbare Energien und smarte Automobiltechnologien. Im ersten Halbjahr 2024 gab es bedeutende Fortschritte in beiden Bereichen – mit einem starken Anstieg der Stromerzeugung aus erneuerbaren Energien und der zunehmenden Bedeutung von Smart Cars. Diese … Continue reading Design einer skalierbaren und modularen Lösung für Datenqualität und Datenvalidierung →

Mehr erfahren

GenAI und mein Familientreffen

Bei den Geschäftssitzungen im letzten Jahr habe ich ein kleines Spiel mit mir selbst entwickelt: Wie lange dauert es wohl, bis das Thema GenAI zur Sprache kommt - unabhängig von der geplanten Tagesordnung? Meistens dauert es nicht lange. Ich glaube, der Rekord für die längste Zeit bis zur ersten Erwähnung am Arbeitsplatz lag kürzlich bei … Continue reading Design einer skalierbaren und modularen Lösung für Datenqualität und Datenvalidierung →

Mehr erfahren

Über Autos, die man noch nicht einmal in der Werbung sieht – Ein Blick auf die Arbeit der Innovatoren bei GlobalLogic

Die Arbeit in der Automobilindustrie, insbesondere wenn es um die Entwicklung von Innovationen geht, die die Hersteller ständig vorantreiben, um auf Trends und Erwartungen der Autofahrer zu reagieren, kann äußerst spannend sein. Es gibt kaum ein besseres Gefühl, als in ein neues Auto einzusteigen und eine Lösung zu entdecken, die man selbst entwickelt hat. Ein … Continue reading Design einer skalierbaren und modularen Lösung für Datenqualität und Datenvalidierung →

Mehr erfahren

Wie bauen Sie Ihre Interdisziplinarität auf? – 7 Tipps für IT-Spezialisten

Die Zukunft gehört denen, die sich nicht in Schubladen stecken lassen. Interdisziplinarität - unser Schlüsselwort - ist die Fähigkeit, Wissen und Fähigkeiten aus verschiedenen Bereichen zu kombinieren, um Herausforderungen und Probleme besser zu verstehen und effizienter zu lösen. Ein IT-Spezialist, der diese Fähigkeit besitzt, profitiert von zahlreichen Vorteilen - von einer größeren beruflichen Flexibilität und … Continue reading Design einer skalierbaren und modularen Lösung für Datenqualität und Datenvalidierung →

Mehr erfahren

Der Einzelhandel als Verschwörungstheorie

Ich war einer der ersten Käufer der ersten Version des Apple Vision Pro AR-Headsets Anfang des Jahres. Ich bin um 5 Uhr morgens aufgestanden, um eine Online-Bestellung aufzugeben, als das Gerät zum ersten Mal zur Vorbestellung verfügbar war. Dann habe ich einen Termin in meinem örtlichen Apple Store vereinbart, um es so früh wie möglich … Continue reading Design einer skalierbaren und modularen Lösung für Datenqualität und Datenvalidierung →

Mehr erfahren

Share this page:

-

-

-

-

URL copied!